※本文原刊登於《科儀新知》220期 108.9, p.74-85 ,經該刊物授權轉載※

張嘉熒、徐逢均、Sumesh Nair、蘇靖傑、林俊佑、許根玉、陳顯禎

中文摘要

在本研究中發展雷射病蟲害防治儀,其結合了單眼立體視覺(monocular stereo vision)、快速雷射掃描(rapid laser scanning)與智慧影像辨識(intelligent pest recognition)等關鍵技術,應用於農業害蟲種群數量控制。選擇小白紋毒蛾(Orgyia Postica)與台灣黃毒蛾(Porthesia Taiwana)這兩種常見的害蟲做測試,將其標定完成之原始圖像用於YOLO演算法訓練與辨識,在YOLO演算法框選區域,再針對不同的害蟲做影像處理來檢測出害蟲的頭部,若是小白紋毒蛾則先需要將影像之色彩空間由RGB轉換成HSV後再進行頭部檢測的影像處理,並通過使用k均值聚類演算法(k-means clustering algorithm)定位出害蟲頭部的中心座標值,使雷射掃描系統能精準地控制雷射光束照射在害蟲頭部。實驗結果指出在波長450 nm、功率1.735 W、光斑直徑2.5 mm的條件下,二齡以上的台灣黃毒蛾幼蟲在照射1.2 sec後會使其無法進一步攝入食物。因此,所發展之雷射病蟲害防治儀是能夠有效地控制害蟲種群的方法。

關鍵字:單眼立體視覺、快速雷射掃描系統、智慧影像辨識、小白紋毒蛾、台灣黃毒蛾、病蟲害防治。

一、前言

農民為了保護未收成的農作物不受到昆蟲、動物的破壞,目前最普遍的做法是噴灑農藥來防治病蟲害,近年來雖然人民與政府皆有共識,積極推廣無藥農業,但是成效緩慢。為了減少病蟲害防治的農藥使用量,在科技進步下,已經有利用雷射光來避免昆蟲、動物入侵1,2不但可避免減少有毒化學物質對環境的傷害,還能提升農業生產效率。然而,雷射應用在蟲害防治上,目前還是處於研究開發的階段,所以目前市場上並沒有太過大規模的使用在蟲害防治,而且雷射蟲害防治技術的成本還是相當高,不過,隨著科技的進步下,雷射蟲害防治系統將很有機會取代農藥的使用來達成無藥農業的目的。因此發展雷射蟲害防治系統的目的為建立一套能取代農藥的使用,避免有毒化學物質對環境的傷害,最終提升農業生產效率用量的。

本篇文章主要結合了蟲害專家學者提供相關領域知識並運用自身軟體優勢於為建立一套能減少農藥用量的雷射病蟲害防治系統。利用自行設計組裝、可調性佳的脈衝式高功率雷射系統,配合單一攝像機及影像辨識系統裝載於嵌入式系統中,運用深度學習技術將資料庫中的害蟲加以訓練,並且經由影像辨識系統自動識別出對農作物有害的害蟲位置,主動調整雷射功率至不傷及作物的情況下,特別針對這些害物以雷射進行直接組織毀壞並為求更有效率的抑制害蟲,使用局部雷射於蟲的弱點區,以減少功率的消耗及縮短雷射的時間以達快速及有效的成果。

二、關鍵技術開發

1. 單眼立體視覺(monocular stereo vision)

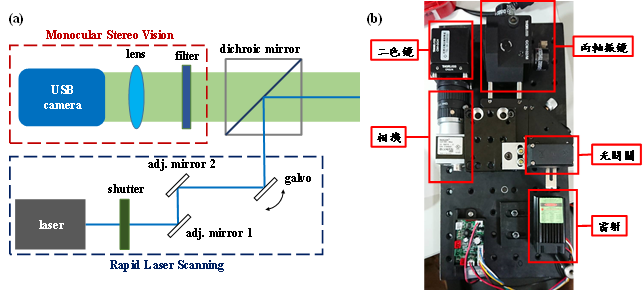

單眼立體視覺系統與雷射掃描系統是採用同軸光學的設計架構,可以使雷射出光與影像擷取經由相同的角度進出,如此一來可以避免不同視角所造成的誤差,只要相機所接收到的目標物體沒有被東西擋住,雷射的路徑應該也是可以暢通地照射在目標物體上。圖1為雷射病蟲害防治儀系統之光學架構系統示意圖與實體影像,包含了單眼立體視覺系統與雷射掃描系統之光路系統,其透過二色鏡(dichroic mirror)來整合此兩套系統之光路達成同軸光學的設計架構,在雷射掃描系統上,初步所使用的雷射光源為雷射二極體(laser diode),經由雷射開關來精確地控制雷射光照射在目標物上的能量劑量(energy doses),之後再經過振鏡系統與分色鏡藉此來改變雷射光束的出光角度以達到快速且精準地照射在目標物體上。而單眼立體視覺系統的部分,經由二色鏡與陷波濾波片(notch filter)可以避免高強度的雷射光進入相機而造成相機本身的傷害,由相機取得的二張影像,再搭配自駕車系統所提供的位置資訊,經由目標物體在二張影像中所佔的像素差,再加上已知的像素大小及鏡頭焦距,便可利用簡單的三角幾何原理反推算出目標物體在空間上的座標位置,經由結合上述的各項技術,可以在相機擷取影像後,結合單眼立體視覺與影像辨識得到一個雷射掃描座標位置,在將此座標值所對應的電壓提供給兩軸的振鏡掃描系統,完成雷射病蟲害防治的目的。

圖1. (a)雷射病蟲害防治儀系統之光學架構,包含有單眼立體視覺系統與雷射掃描系統;(b)雷射病蟲害防治儀系統之實體影像。

2. 快速雷射掃描(rapid laser scanning)

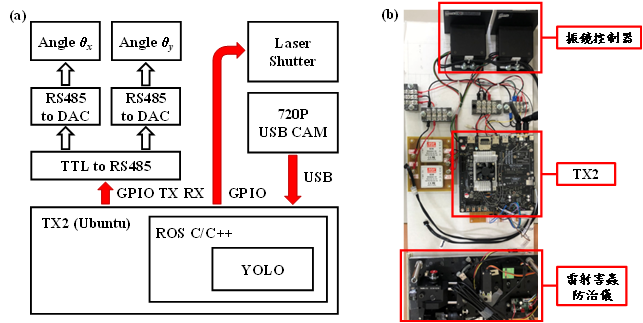

光學掃描方式是被加工物體不動,雷射本身藉由二片高反射鍍膜鏡片,分別在平行方向及垂直方向快速振動以偏轉雷射光的位置,此種可將雷射光束快速偏移進行位置掃描的系統稱之為振鏡系統。而這樣的系統亦適合運用在棗樹病蟲害的防治系統上,當影像系統擷取到害蟲、蟲卵或罹病部位的影像後,經過辨識、定位、及範圍確認,即可啟動振鏡掃描系統,使雷射光束進行全面積多重快速掃描或精密快速的定位,完成罹病區或害物的清除作業,尤其再輔以自動變焦系統,調控不同的焦距,以控制不同的雷射光斑輸出,即可迅速調整單位面積的雷射能量,確保目標物體之清除,且不傷及作物。在此,為了可以掃描不同大小區域範圍,我們採用兩軸光學振鏡(GVS202,Thorlabs)作為掃描的工具。此光學振鏡在輸入±10V的工作電壓時可以達到±12.5°的機械角度,並利用其高達1 kHz 的掃描頻率快速地反覆掃瞄目標物所在的位置區域。由光學振鏡組所組成的二維掃描系統、雷射光源與快門來建立初步的病蟲害雷射防治系統,經由結合深度學習來辨識出物體的位置,與運算得到的空間座標輸入給控制中樞來完成病蟲害雷射防治系統的建立。目前系統控制中樞是採用嵌入式系統NVIDIA Jetson TX2,經由Ubuntu作業系統下的機器人作業系統(Robot Operating System,ROS)來溝通所有的外部控制硬體,包含USB相機、雷射開關與振鏡控制器,控制系統流程如圖2(a)所表示,經由USB相機所取得的影像輸入系統中,經過辨識運算取得農業害蟲在輸入圖像中的座標位置,再透過TX2上的通用型之輸入輸出(general-purpose input/output,GPIO)介面溝通的RS485通訊之數位類比轉換器(digital to analog converter,DAC),藉由輸出類比電壓控制雷射振鏡的角度來使雷射光正確地照射在目標物體上,同時間也經由GPIO來控制雷射開關來精確地控制雷射光能量的照射劑量,圖2(b)為雷射病蟲害防治儀控制系統的實體影像,透過嵌入式系統NVIDIA Jetson TX2硬體來完成整體的控制。

圖2. (a)雷射病蟲害防治儀控制系統之介面控制架構圖;(b)整體控制系統之實體影像。

為了讓雷射光束精準地照射在目標物體的位置上,經由目標物體在影像中的座標位置需要經過校正來取得其在真實空間中的座標,假設相機的像素尺寸為dcam,而且其所使用的成像鏡頭焦距為f,相機所取得的影像大小為M × N,而目標物的位置座標為(x, y),並且假設影像中心座標為振鏡系統的掃描原點,經由簡單的三角幾何公式可以推導出雷射光束所需要的偏轉角度。在計算出雷射光束所需要的偏轉角度,根據光槓桿原理兩軸振鏡所需要偏轉的角度為雷射光束所偏轉角度的一半,由於所使用的光學振鏡在輸入10 V的工作電壓時可以達到12.5°的機械角度,經由計算可以得到所兩軸振鏡偏轉所需要的電壓值。在取得兩軸振鏡偏轉所需要的電壓數值後,就可以經由TX2來控制雷射光束,使其精準地照射在目標物體上。

3. 智慧影像辨識(intelligent pest recognition)

初步的測試場域為鳳山農試所合作配合之棗園,所使用的Basler彩色相機解析度為1280 ×960,影像鏡頭焦距為12 mm來擷取影像,自行建立害蟲的資料庫,初期測試由取得的兩種害蟲資料庫,使用離線方式訓練並將其訓練結果建構於嵌入式系統NVIDIA Jetson TX2,藉此進行深度學習的計算並且將結果轉換成真實座標位置。

以卷積神經網路(convolutional neural networks,CNN)為基本架構的物件偵測主要分成二大類:二階段偵測及一階段偵測。在二階段偵測中,將物件偵測分成第一步驟的偵測與第二步驟的分類。著名的作法有快速RCNN (regions with CNN features)3, 以CNN為基礎架構利用回歸與分類達到物件偵測及物件分類。以此基礎的變化有R-FCN (region-based fully convolutional networks)4與 FPN (feature pyramid networks)5。在一階段偵測中,是將偵測與分類在同一個步驟中學習完成,著名的方法有YOLO (You Only Look Once)6與SSD (single shot detector)7。這二種一階段的偵測在計算複雜度上都是比二階段偵測輕量很多,在系統上比較有機會達到即時運算的需求。但缺點是比二階段偵測的正確率相近或是比較差8,9。

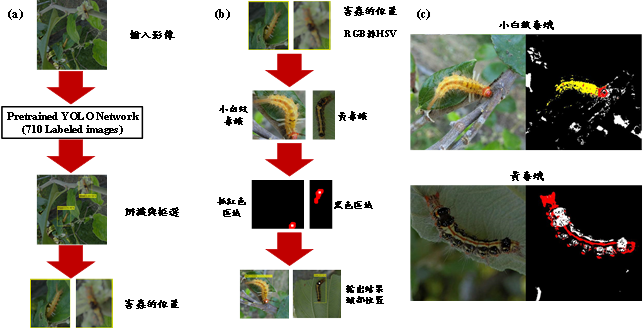

在辨識率與計算速度上的考量,我們使用YOLO的架構訓練害蟲資料庫,在訓練之前,我們將取樣的影像做縮小3 ~ 4.5倍後,任意角度(間隔10度)旋轉並調整亮度,再由圖片心中切成448 × 448的尺寸,當成學習資料,以增強算法的強健性及辨識度。收集的資料庫針對棗園常見的二種害蟲,小白紋毒蛾(Orgyia postica)及台灣黃毒蛾(Porthesia taiwan),使用710張圖做訓練,及使用人工標定的500張圖做測試,測試流程如圖3(a)所示。經由YOLO的架構上無修正的使用原網路設定,運用YOLO的預測模型加上710張影像重新訓練一次權重值適合害蟲的網路架構710張圖離線訓練後,利用訓練好的網路架構將鏡頭的即時影像輸入網路架構中,進行辨識與框選;再經由框選與分類的結果,針對每一個框選區再做一次精準的定位流程如圖3(b)所示,為了使雷射更有效率的使用,我們定位出害蟲弱點部份即為頭部,YOLO分類的結果選擇使用不同的影像處理方式,利用二種害蟲頭部顏色紋理不同的特性,小白紋毒蛾的身體呈現黃色且頭部呈現紅色的特性投影顏色模組於HSV中有可效分離黃色與紅色區域依據;而黃毒蛾與小白紋毒蛾有不同的顏色紋理,頭部顏色紋理的部份為黑色分佈占較大的比重,因此使用抓取黑色區域後標示相對位置為紅色,並針對紅色區域取重心設定頭部座標。

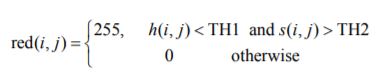

將辨識後的結果區塊經由RGB轉換到HSV Model,各自分成三個頻道H、S及V,每個頻道的解析度為長為m,寬為n,若辨識結果的分類為小白紋毒蛾,即使用下列公式做過濾將區塊中的影像紅色部份做二值化成為一張red圖,在此公式中,TH1為紅色角度的閥值設定為0.08,TH2為飽和度的閥值設定為0.6,h值的分佈0~1;s值的分佈0~1。

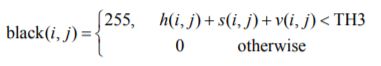

若辨識結果的分類為台灣黃毒蛾,需要做黑色的過濾,因此會使用下面公式,公式中一樣使用HSV資訊,並將影像黑色部份做二值化成為一張black圖;TH3為每個點的色度+飽和度+亮度的值總合閥值設定為0.3。

過濾完的結果如圖3(c)所示,可將小白紋毒蛾紅色的部份使用紅色標示出,黃毒蛾黑色的部份使用白色標示出並使用k-means10的分群法得到每一群的重心,再取最大的那一群的重心結果輸出給雷射座標。如圖3中圖重心部份使用白色方格表示。

圖3. (a)為YOLO影像辨識;(b)為害蟲頭部定位流程;(c)為偵測顏色過濾的結果。

三、測試結果

1. 兩種害蟲之辨識結果

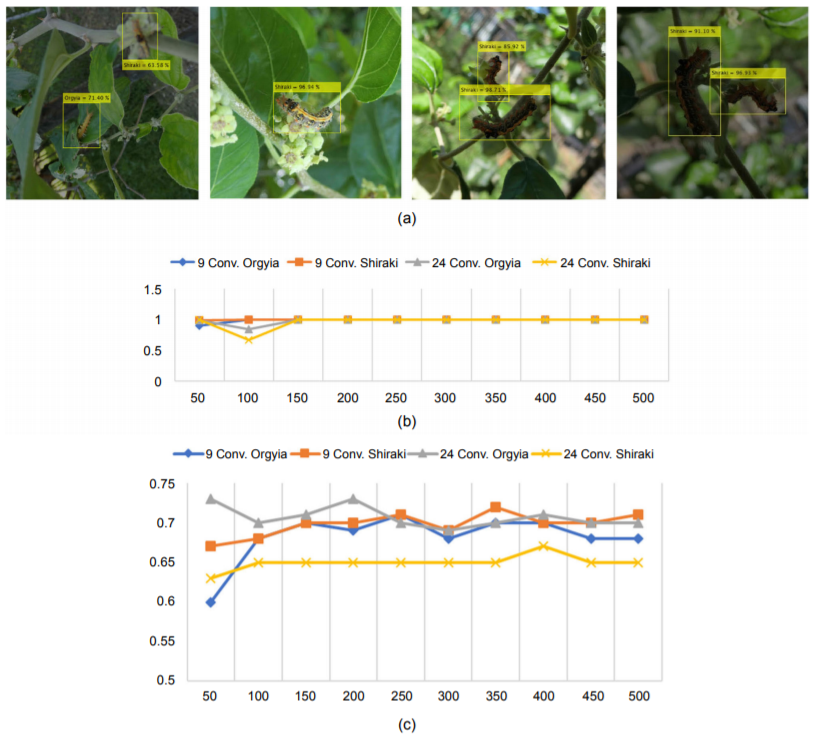

(1) YOLO辨識結果分析:由於在實際環境中,害蟲並非鋼體會有不同的體態角度,及不同的環境亮度變化,因此在訓練時考量這些環境變因有加入不同旋轉角度和不同亮度的訓練及測試影像如圖4(a)所示,在實際場景中,背景複雜且亮度不一致經由YOLO網路架構使用ResNet-50的基本架構的辨識。在訓練的迭代次數實驗使用9層與24層測試迭代50~500次分析收斂程度,實驗結果得到針對訓練影像在迭代150次以上可達辨識率100%的收斂結果,如圖4(b)。使用不在訓練資料庫外的另外500張測試影像,測試辨識率,使用9層與24層的結果辨識率皆達100%,因此加入IoU (intersection over union)11分析與人工標定出的框與偵測結果框的重疊率如圖4(c)所示,雖然在辨識率達100%,但在IoU的數值1表示為人工標定的框與偵測框100%重疊,相反地,數值為0表示人工標定與偵測框完全無重疊,在此分析上無法有接近1的數值結果,主要原因是因為多人標定,而且害蟲體態角度無法用統一的標定手法,因此計算時無法達到接近1的數值結果。

圖4. 使用YOLO的偵測結果:(a)運用不同情況影像測試算法強健度,不同亮度與複雜背景實際圖;(b)訓練圖710張,使用9層與24層分析迭代次數結果;(c)訓練加入測試影像並使用IoU分析結果。

(2) 害蟲頭部定位結果分析:頭部定位辨識率結果如表1所示,總定位辨識率為62%當中小白紋毒蛾辨識率為75%,台灣黃毒蛾58%;將顏色過濾結果如圖5(a)所示,經由上述的公式過濾後,可二值化得到需求的資訊,再經由k-means的結果如圖中白色框定位出中心點座標;如圖5(b)為小白紋毒蛾無法正確定位出的圖,由於使用紅色二值化,因此在無此資訊及頭部被遮蔽的情況下無法正確定位出頭部的位置;如圖5(c)為台灣黃毒蛾無法正確定位出的圖,由於使用黑色二值化,由於使用的黑色過濾上無法有效過濾出需要的頭部黑色資料,如每張彩色圖右邊的黑底圖都為全黑表示在黑色過濾時沒有任何一個像素點為黑色,因此無法定位出有效的位置使得頭部定位的正確率較低。

表1 頭部定位辨識度分析表。

圖5. 針對害蟲頭部定位結果:(a)顏色過濾定位結果圖;(b)小白紋毒蛾無法正確定位圖;(c)台灣黃毒蛾無法正確定位圖。

2. 定位精準度的測試結果

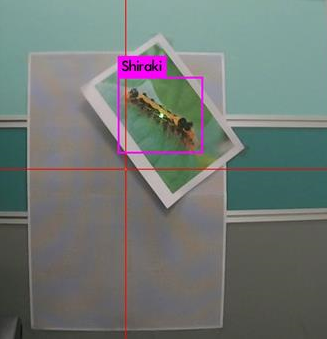

根據目前的雷射病蟲害防治儀之系統設計,相機上感光元件的一個像素點尺寸大小為3.75 μm,成像鏡頭的焦距為12 mm,因此,經由影像提供的角度解析度約為0.018°(像素除以鏡頭焦距);而在雷射掃描系統上,由於光學振鏡在輸入±10 V的工作電壓時可以達到±12.5°的機械角度,且使用的DAC在±10 V的輸出時可以提供12 bit解析度,換算下來光學振鏡能夠達到約0.006°的角度解析,經由於光槓桿原理可以得出雷射光束的掃描角度解析度為0.012°,在假設目標物體距離為120 cm的情況下,影像目標物與雷射光目標物的理論誤差值約只有0.13 mm (120 cm × (0.018° - 0.012°) ÷ 180° × π= 0.013 cm),因此,目前的雷射病蟲害防治儀系統設計是沒有問題的,雷射掃描系統可以經由影像系統提供的座標位置來精準地定位在目標物體上,而經由實際的實驗測試結果,誤差值約為1至2 mm左右;圖6為雷射病蟲害防治儀的初步測試實驗結果,影像中的紅色線交點為雷射光束的掃描原點,由相機所取得的影像經過YOLO網路計算後可框選出害蟲區域,並且將此區域的中心座標回傳,並驅動光學振鏡讓雷射光束偏折至目標物體的座標位置上,洋紅色為影像辨識所框出的害蟲位置,上面名稱為害蟲的種類(台灣黃毒蛾),綠色光點為雷射光所照射的位置,正好落在框選區域的中心位置附近。

圖6. 雷射病蟲害防治儀的初步測試實驗結果,紅色線交點為雷射光束的掃描原點,洋紅色為YOLO演算法影像辨識所框出的害蟲位置與害蟲種類。

然而在實際應用的農地場域,必須克服自然環境下可能會引入相關的誤差,進而導致雷射光束無法正確地定位在目標物體上,其中最主要的因素為當地面不平整時,車輛傾斜時所造成與目標物體的距離發生改變與車輛移動,進而造成目標物體在影像中的座標產生改變,假若影像辨識速度非常快時,就能夠達到即時的座標修正,很不幸的是由於系統硬體的限制,影像辨識速度大約小於每秒15張影像(~67 ms),因此為了解決此問題,目前的構想是利用車輛中的慣性測量單元(inertial measurement unit,IMU)來即時取得車輛的資訊,由於雷射病蟲害防治儀是固定在車輛上,所以車輛的IMU資料可以直接取得來使用,透過IMU資訊來即時修正目標物體在影像中的座標位置,讓雷射光束能夠正確地照射在目標物體上。

3. 雷射害蟲防治於台灣黃毒蛾幼蟲的測試結果

在傳統的做法是定期噴灑農藥來防治病蟲害,但是大量使用農藥會對環境產生許多的負面影響,因此,將雷射光源應用在病蟲害的防治上,可避免對環境產生過多負面影響,並且只要提供穩定的電源供應就可以持續系統的運行,不需要重新添加藥劑。然而,雷射病蟲害防治(laser pest control)目前尚缺乏全面的雷射適用參數研究數據,為了進行有效率且不傷及作物的雷射病蟲害防治,需量測對於不同棗病蟲害適用的最有效雷射波長,及該波長下最不會傷及棗子的雷射能量。此防治方法的概念在1999年就已經有人提出來,可將目前相關的研究文獻與實際的測得參數進行整合:在果蠅的防治上,有研究團隊利用532 nm與1064 nm兩種不同波長的雷射光照射果蠅幼蟲,發現較有效率的波長為532 nm,能量密度只需要6 kJ / m2就可以殺死果蠅幼蟲12;同時也有研究團隊採用半導體雷射波長650 nm來殺死果蠅幼蟲,研究指出當雷射功率大於60 mW下照射1282秒就可以讓果蠅幼蟲的死亡率達到99%,研究結果也指出在雷射功率低於40 mW時,反而會促進果蠅幼蟲的生長13;而在瘧蚊的防治上,研究指出綠光與遠紅外線波段的雷射可以更有效率地殺死瘧蚊14。此外,在蚜蟲的防治研究上,使用532 nm雷射,功率500 mW照射3秒就可顯著殺死大量蚜蟲死亡15。

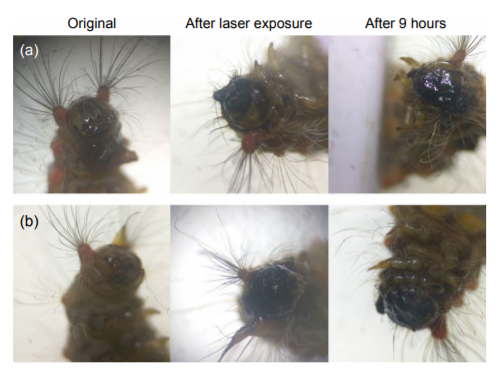

利用雷射來防治蟲害的實驗,我們先針對台灣黃毒蛾二齡以上的幼蟲來進行初步的實驗測試,有國外研究指出幼蟲頭部具有許多感測器,可以幫助幼蟲來探索週圍環境與尋找食物來源16,因此我們利用雷射來照射幼蟲頭部,使頭部的感測器失去功能性,而為了避免幼蟲在實驗過程中移動,會預先將幼蟲放在冰塊上10分鐘使其活動力大大地降低。初步的實驗測試所使用的雷射為波長450 nm的雷射二極體,並且利用透鏡組使其照射在目標物體上的雷射光斑直徑為2.5 mm,圖7為初步的實驗結果,由左至右為分別為照射雷射光前、雷射光照射後與照射完成經過9小時後之台灣黃毒蛾幼蟲頭部影像,初步測試實驗所使用之雷射光功率均固定為1.735 W,雷射光照射時間分別為1.2秒,如圖7(a)所示,與照射2秒,如圖7(b),而且被雷射光照射過後的台灣黃毒蛾幼蟲會被放置在葉片上,且持續觀察有無進食的行為,初步的實驗結果顯示在經過雷射光照射1.2秒以上,台灣黃毒蛾幼蟲頭部的感測器失去其功能性而使其無法進食,此時的能量密度約為424 kJ/m2,未來將更精準地測試所需的雷射劑量,並且試著在害蟲還在卵塊時期便利用雷射將其破壞,使雷射光能夠更有效率地應用在害蟲的防治上。

圖7. 台灣黃毒蛾幼蟲頭部影像,由左至右為分別為照射雷射光前、雷射光照射後與照射完成經過9小時後;(a)雷射光照射1.2秒;(b) 雷射光照射2秒。

四、結論

我們成功地開發出一套雷射病蟲害防治儀用於農業害蟲種群數量控制,結合單眼立體視覺、快速雷射掃描與智慧影像辨識的關鍵技術,在小白紋毒蛾與台灣黃毒蛾這兩種常見的害蟲的防治上,利用YOLO網路架構的學習結果,針對訓練影像可達辨識率100%的收斂結果,在通之後的影像處理,在小白紋毒蛾的頭部定位正確率為0.75,而台灣黃毒蛾的頭部定位正確率為0.58,達到整體定位正確率為0.62;在雷射掃描系統部份,在目標物體距離為120 cm時,雷射定位的誤差值約為1~2 mm左右;在台灣黃毒蛾的雷射防治上,實驗結果指出在波長450 nm、功率1.735 W、光斑直徑2.5 mm的條件下,二齡以上的台灣黃毒蛾幼蟲在照射1.2秒後會使其無法進一步攝入食物。因此,藉由智慧影像辨識、單眼立體視覺與快速雷射掃描技術所發展之雷射病蟲害防治儀似乎是能夠有效地控制害蟲種群的方法,能夠進一步防止農作物被害蟲損害並提高產量。

誌謝

本研究承蒙科技部計畫(MOST 107-2321-B-009 -003)支持。

參考文獻

- http://technews.tw/2017/12/14/star-wars-meets-fruit-farms-as-lasers-deter-thieving-birds/

- https://www.itsfun.com.tw/%E9%9B%B7%E5%B0%84%E9%A9%85%E9%B3%A5/wiki-4107201-306179

- S. Ren et al., IEEE Transactions on Pattern Analysis and Machine Intelligence 39(6), 91-99 (2015).

- J. Dai et al., Advances in Neural Information Processing Systems 29 (NIPS 2016) 379-387 (2016).

- T. Y. Lin et al., 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), DOI: 10.1109/CVPR.2017.106.

- J. Redmon et al., 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), DOI: 10.1109/CVPR.2016.91.

- W. Liu et al., Computer Vision – ECCV 2016, https://doi.org/10.1007/978-3-319-46448-0_2.

- T. Y. Lin et al., 2017 IEEE International Conference on Computer Vision (ICCV), 2980-2988 (2017).

- K. He et al., 2017 IEEE International Conference on Computer Vision (ICCV), 2961-2969 (2017).

- D. Arthur and S. Vassilvitskiim, Proceedings of the Eighteenth Annual ACM-SIAM Symposium on Discrete Algorithms (SODA 2007), DOI: 10.1145/1283383.1283494.

- H. Rezatofighi et al., 2019 IEEE Conference on Computer Vision and Pattern Recognition (CVPR), https://arxiv.org/abs/1902.09630.

- K. Obayashi et al., J. Jap. Soc. Agric. Machin. 67, 93- (2005).

- K. Ren et al., Chinese J. Lasers 33, 1148- (2006).

- M. D. Keller et al., Sci. Rep. 30, 892- (2015).

- P. D. Dix et al., 2016 ASABE Annual International Meeting, doi:10.13031/aim.20162461448.

- I. Kandori et al., PLoS ONE 10(7), e0131596 (2015).

作者簡介

張嘉熒小姐為國立成功大學電腦與通訊研究所博士,現任國立交通大學智慧光電農業機器人研究中心助理研究員。

徐逢均先生為國立交通大學光電學院影像與生醫光電研究所博士候選人。

Sumesh Nair先生為國立交通大學光電學院影像與生醫光電研究所博士候選人。

蘇靖傑先生為國立成功大學工程科學系碩士在職專班,現任國立交通大學智慧光電農業機器人研究中心工程師。

林俊佑先生為國立成功大學工程科學系博士,現任國立交通大學光電學院影像與生醫光電研究所助理研究員。

陳顯禎先生為美國加州大學洛杉磯分校機械工程學系博士,現任國立交通大學光電學院院長。